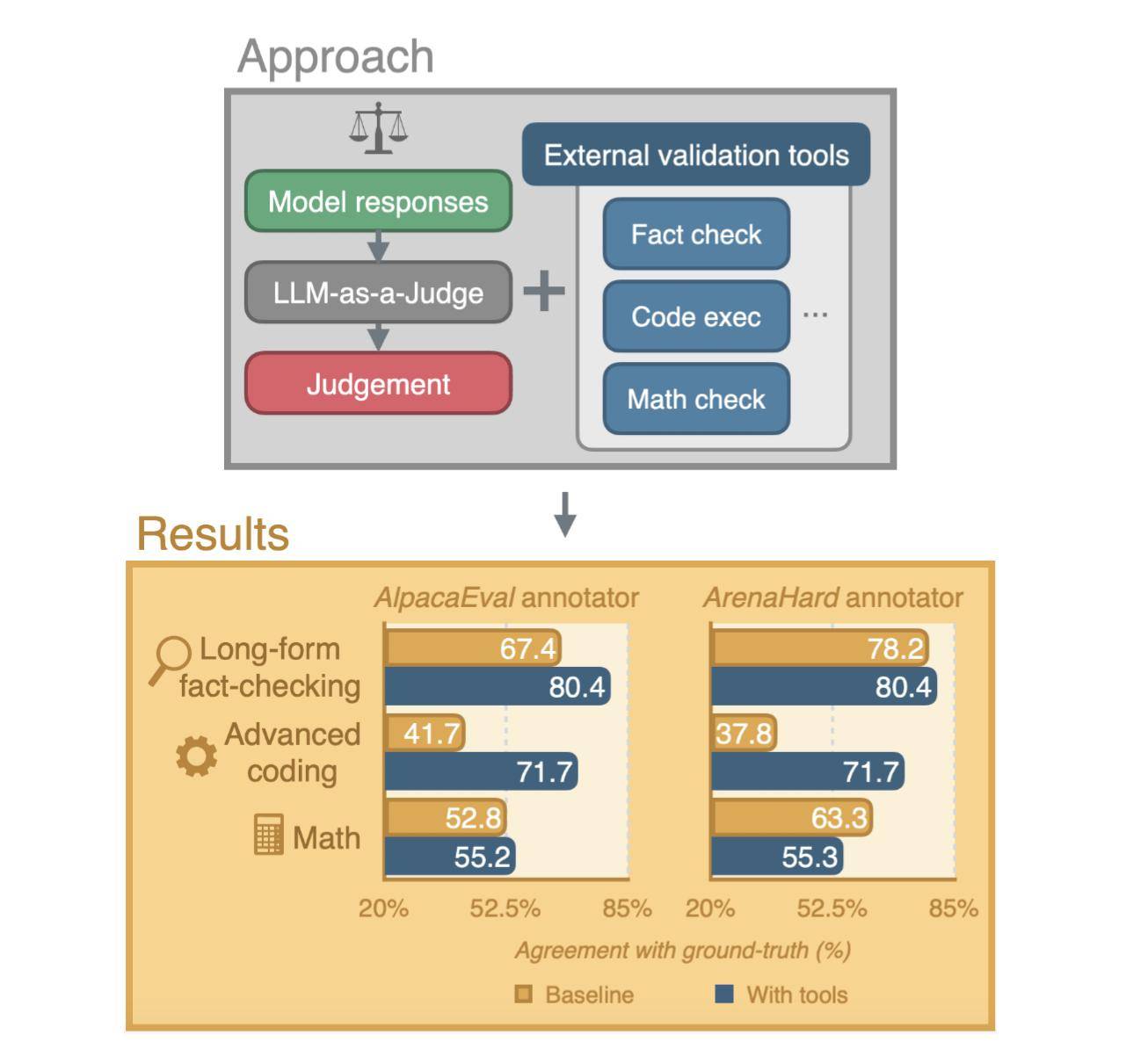

近日,科技界迎来了一项新的合作成果,苹果公司与剑桥大学联手推出了一项创新的AI评估系统。这一系统旨在通过引入外部验证工具,提升AI评审员的能力,进而增强评估的整体质量。

在评估大型语言模型(LLM)的过程中,研究人员和开发者常常借助AI的力量,也就是所谓的“LLM作为评审员”。然而,这一方法也面临着不少挑战,特别是在处理长篇事实核查、高级编码以及复杂数学问题等任务时,评估的准确性往往会受到影响。

为了克服这些挑战,苹果与剑桥大学的研究人员共同发表了一篇新的研究论文,详细介绍了一种新的评估系统。该系统通过为AI评审员配备外部验证工具,旨在克服人类和AI在注释过程中的局限性,从而提高评估的准确性。

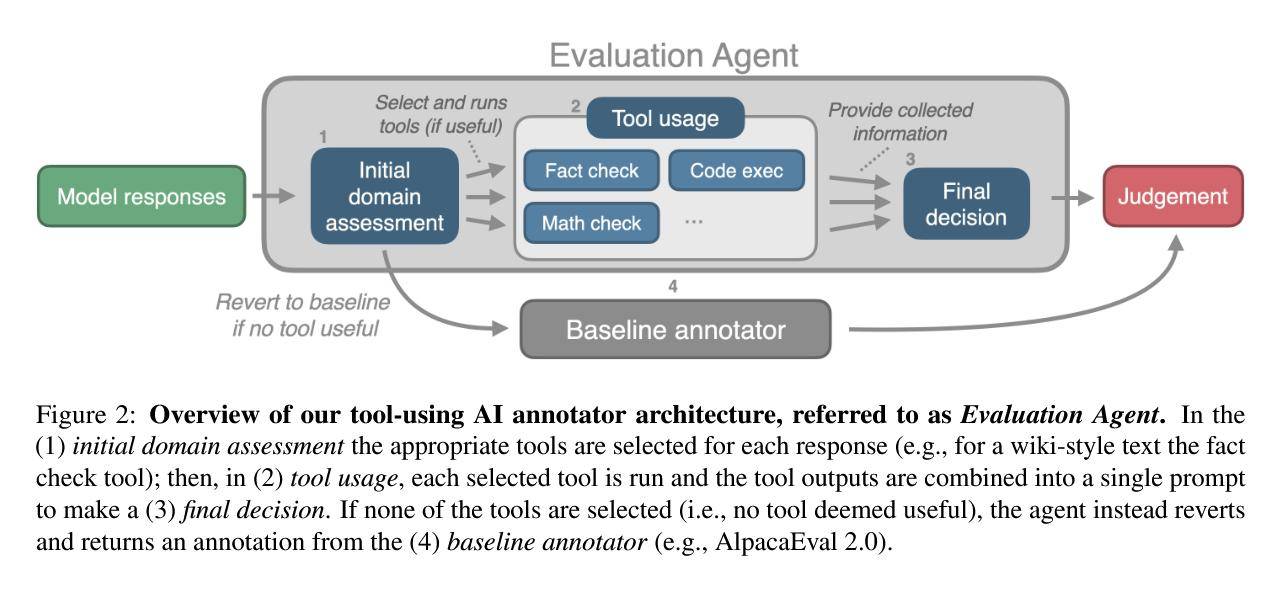

人类评审员在评估过程中可能会受到时间限制、疲劳以及个人写作风格等因素的影响,从而产生偏见。而AI在处理上述复杂任务时,也面临着不小的困难。为了解决这些问题,研究人员创建了一种具有自主性的评估代理。该代理能够评估响应,并根据需要选择使用外部工具,以确保评估的准确性。

评估过程主要包括三个步骤:首先是初始领域评估,其次是工具的使用,最后是最终决策。在工具使用环节,事实核查工具会利用网络搜索来验证响应中的事实准确性;代码执行工具则会借助OpenAI的代码解释器来运行并验证代码的正确性;而数学核查工具则是代码执行工具的一个专门版本,用于验证数学和算术运算的准确性。

如果评估代理判断没有合适的工具可以帮助判断,那么系统将默认使用基线LLM注释器,以避免在简单任务上进行不必要的处理,从而可能导致的性能下降。